« Le dormeur doit se réveiller », Frank Herbert

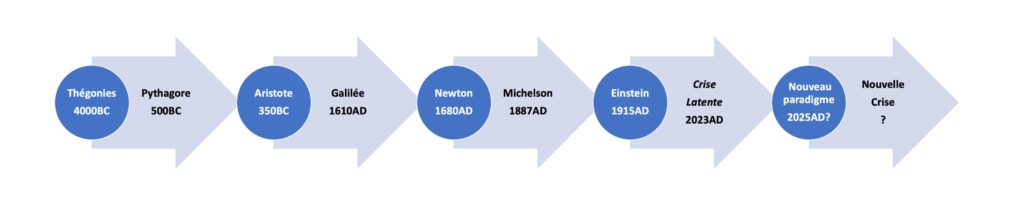

Les révolutions scientifiques – Les 4 premiers paradigmes – Les 3 premières crises – Une crise latente – Le modèle standard – RG – PQ – Critique du modèle standard

L’objectif de cette page est d’évaluer la situation scientifique en 2022 et de l’inscrire dans l’histoire des sciences. Le développement des sciences, depuis son origine antique, suit des cycles de « révolutions scientifiques ». Ces cycles, ainsi que leurs principaux protagonistes, sont décrits. Le paradigme scientifique actuel repose sur le modèle standard de la physique moderne (Relativité Générale-RG et Physique Quantique-PQ), qui est lui-même analysé. Bien que toutes les informations contenues dans cette page soient connues des spécialistes, leur mise en perspective permet de comprendre la situation actuelle: l’humanité rentre dans une période de « crise » scientifique. Passée la prise de conscience, on pourra travailler à la reconstruction. Et pour le collectif Philolaos, il n’y a qu’une seule issue: l’unification de toutes les sciences via un changement profond de paradigme.

Les révolutions scientifiques

Observons la façon dont l’homme a répondu à l’une des questions philosophiques existentielles « Quelles sont les règles du jeu ?» au cours de l’histoire de l’humanité. Thomas Kuhn, dans un article intitulé « la structure des révolutions scientifiques », fournit en 1962AD un vocabulaire et une analyse pertinente de la façon dont la science a évolué depuis l’origine des temps. Il observe que l’évolution de la connaissance scientifique suit des cycles alternant entre une phase stable caractérisée par un « paradigme » et une phase de crise instable pendant laquelle le paradigme est remis en question. La crise aboutit inexorablement à un nouveau paradigme qui remplace les connaissances et les croyances précédentes.

Le paradigme est une organisation structurée de l’ensemble des croyances/connaissances jugée suffisamment cohérente et communément admise comme « vraie » par la majorité des hommes. Ce paradigme fixe un cadre stable de réflexion qui permet à tout un chacun de mener de la « recherche normale », i.e. d’améliorer en profondeur les connaissances de la nature… sans jamais sortir du cadre. En effet, pendant cette phase de stabilité, la communauté devient (très) peu tolérante vis-à-vis de ceux qui s’aventurent en dehors du cadre. Pendant cette phase de stabilité, l’afflux d’observations nouvelles et l’ajout de nouveaux concepts en accord avec le cadre permet d’améliorer considérablement l’étendue des connaissances. Cette phase est donc clé pour étoffer le spectre des connaissances, rationnaliser des observations et pour partager celles-ci entre pairs, qui sont tous à peu près « sur la même longueur d’onde » en parlant tous à peu près « le même langage ».

Puis, on commence à détecter des anomalies, i.e. des observations en contradiction manifeste avec les projections attendues dans le cadre du paradigme. Au départ, l’homme de la recherche normale tord légèrement le bras du paradigme pour faire « rentrer » les anomalies dans le cadre. Ce faisant, il le modifie légèrement, subrepticement, souvent avec la tendance de perdre le « sens physique » originel du cadre.

Lorsque les anomalies dépassent un certain seuil d’élasticité du cadre (en qualité ou en quantité), alors l’humanité rentre en période de crise : le paradigme n’est plus tenable. De petits groupes se créent, partant dans des directions très différentes, toutes caractérisées par le fait de remettre en question le cadre, plus ou moins radicalement. La crise peut durer entre quelques dizaines et quelques centaines d’années ! En général un groupe unique, dont l’intuition sera jugée a posteriori comme « la bonne », fixe alors un nouveau cadre. On observe cependant toujours que les idées de ce petit groupe étaient déjà présentes avant, et simultanément dans différentes zones géographiques (pour ne pas dire partout !). La plupart du temps, on découvre même que les idées étaient présentes depuis longtemps, mais qu’elles n’étaient pas « audibles » car inorganisées et, surtout, hors paradigme. On peut citer par exemple Aristarque de Samos qui a proposé en 250BC, soit 1800 ans avant Copernic, un modèle héliocentrique avec « preuves » à l’appui… Mais il avait raison trop tôt!

Les 4 premiers paradigmes

Nous avons repris le vocabulaire de Kuhn pour identifier clairement les 4 premiers paradigmes de l’histoire de l’humanité, avec leurs promoteurs ainsi que la nature des connaissances associées:

- Le premier paradigme est basé sur des théogonies, c’est à dire des croyances religieuses ou philosophiques qui expliquent la genèse du monde. Ce premier paradigme apparaît en 4000BC en Mésopotamie en même temps que l’écriture. Les croyances se répandent à travers la planète, elles évoluent (un dieu, 2, 3, une multitude, aucun, etc) mais les principes scientifiques fondamentaux restent les mêmes: le paradigme repose sur des rapports commensurables (nombres entiers, arithmétique modulaire des premiers calendriers, nombres rationnels, fractions dyadiques), les formes circulaires, la beauté de la musique et l’harmonie des cycles astronomiques. Le premier paradigme dure 3500 ans jusqu’en 500BC. La période de stabilité scientifique se termine avec la crise déclenchée par les pythagoriciens.

- Le deuxième paradigme est introduit par Aristote en 350BC. Il met fin à la crise déclenchée par les pythagoriciens, grâce à une sécularisation de la théogonie grecque. Les dieux sont remplacés par un démiurge. Aristote définit la connaissance de la nature (Physica), une nouvelle théorie du Tout, grâce à 4 principes (matière, forme, causalité, ordre) et une logique déductive binaire (les syllogismes basés sur le tiers exclu). On y retrouve également les anciens concepts d’immanence, de finitude, le géocentrisme, le rejet du vide, un principe anthropique fort… S’en suivent 1960 années stables de « science normale », jusqu’à la nouvelle crise Galileo-Copernicienne de 1610AD.

- Le troisième paradigme est introduit par Newton en 1680AD dans ses « Principia ». Il met fin à la crise déclenchée par Galilée 70 ans plus tôt. Il s’appuie sur la notion de continuité du temps et de l’espace (il développe pour cela le calcul d’infinitésimaux), le principe de relativité (galiléenne), la gravitation universelle, la géométrie euclidienne, les équations différentielles et les nombres réels. La lune de miel va durer 207 ans avec la découverte en particulier (en restant dans le cadre) de la thermodynamique, de la chimie et de l’électromagnétisme! … jusqu’en 1887AD lorsque Michelson démontre l’invariance de la vitesse de la lumière, c’est la troisième crise.

- Le quatrième paradigme est introduit par Einstein en 1915AD avec la relativité générale et la dualité onde/particule pour expliquer l’effet photoélectrique (clé de la physique quantique). Le paradigme s’appuie sur une géométrie non-euclidienne, l’algèbre générale, les nombres imaginaires, la théorie de la mesure (incluant les phénomènes aléatoires). Il met fin à la crise initiée par Michelson en 1887AD. Mais le monstre finit par échapper à son créateur qui ne la reconnait plus vraiment: la mécanique quantique repose désormais sur des phénomènes aléatoires et la relativité générale sur la notion d’énergie/matière noires totalement empiriques. Le paradigme dure plus de 108 ans (jusqu’à aujourd’hui), période stable de science normale très propices au développement de nouvelles technologiques. Mais la quatrième crise est latente…

On observe que chaque changement de paradigme s’accompagne d’une évolution du niveau de connaissances mathématiques, i.e. de la nature des outils mathématiques nécessaires pour établir sa cohérence. Il semble donc que les mathématiques tiennent une place de choix dans l’élaboration d’un paradigme. Comme si à un niveau de connaissance mathématique donné correspondait un paradigme. La crise prend fin avec un nouveau paradigme et le cycle recommence jusqu’à la crise suivante, caractérisée par l’observation de nouvelles anomalies… Pour creuser cette influence de l’histoire des sciences et des mathématiques sur les paradigmes, se reporter à la page spécifique de ce site « sciences ou croyances? ».

Les 3 premières crises

Voyons maintenant plus en détail les anomalies, ainsi que leurs découvreurs, qui sont donc à l’origine des trois grandes crises avérées de l’humanité:

- La première crise est déclenchée en 500BC par l’inventeur du concept de philosophie qui s’interroge sur la place de l’homme dans l’univers, Pythagore. Il suit les traces de Thalès de Milet et rassemble les connaissances sumériennes, égyptiennes et védiques grâce à un parcours initiatique exceptionnel. Il observe alors un « ordre caché » dans la musique et crée une nouvelle discipline appelée « mathématique » pour l’étudier. Pythagore développe ainsi l’arithmétique, il découvre la dualité des nombres pairs et impairs (les seconds étant « premiers de naissance »). En recherchant cet ordre caché, Pythagore se convainc que « tout est nombre ». L’anomalie suprême est la découverte par les pythagoriciens de l’existence des nombres incommensurable (irrationnels, comme la racine carrée de 2). Pythagore ne croit pas en « dieu » mais dans un concept vitaliste et à la transmigration des âmes. Les théogonies ont assez duré! La crise dure 150 ans et se termine en 350BC avec Aristote qui réconcilie une grande partie de ces pensées et observations (pas toutes) avec le nouveau paradigme qu’il appelle la « Physique ».

- La deuxième crise était latente sous l’impulsion de Copernic en 1530AD, mais elle est formellement déclenchée par Galilée en 1610AD grâce aux observations faites avec sa lunette astronomique . Tout commence par l’observation de la fin du géocentrisme (certains objets ne tournent pas autour de la Terre). Galilée formule également la relativité galiléenne (qui n’est autre que l’écriture en langage mathématique de l’inertie de Platon, mais qui met à mal l’absolutisme: les vitesses deviennent relatives). A nouveau, ce sont les observations qui viennent bouleverser l’ordre établi, pas les modèles. Elles nourrissent de nouveaux modèles par de nouveaux concepts abstraits comme le « zéro », l’infini et la continuité du temps et de l’espace (les nombres réels apparaissent) qui mettent fin au principe d’immanence. Descartes abonde en proposant une méthodologie scientifique basée sur la recherche en toutes choses d’un ordre. La crise dure 70 ans et se termine en 1680AD avec les « Principia » de Newton.

- Alors que les physiciens pensaient tout maîtriser depuis la récente découverte des équations de Maxwell et de la thermodynamique, une expérience a tout remis en cause en révélant une seule anomalie: la troisième crise est déclenchée par Michelson en 1887AD avec la mesure de l’invariance de la vitesse de la lumière et l’absence de déplacement de l’éther. Étonnamment, alors que l’invariance de la vitesse de la lumière pourrait militer pour un retour à des notions d’absolutisme, c’est l’inverse qui se produit. De nouveaux concepts mathématiques tels que les espaces non-euclidiens, les nombres imaginaires, la stochastique (science des phénomènes aléatoires) vont nourrir la nouvelle crise. La crise dure 28 ans jusqu’en 1915AD lorsque Einstein aura décrit à la fois la relativité restreinte et générale, la modélisation du mouvement brownien et l’effet photoélectrique (clé de la physique quantique). Pour la première fois, la recherche d’un ordre caché, qui a pourtant déclenché la crise, va disparaitre de la solution… Kant est passé par là, il a démocratisé l’empirisme. Le nouveau paradigme, que l’on appelle le « modèle standard de la physique moderne » repose sur une généralisation mathématique empirique ainsi que sur les concepts de vide (qui remplace l’éther) et de probabilité.

Une quatrième crise latente…

La quatrième crise n’est pas formellement déclenchée, elle est latente: depuis longtemps déjà personne ne comprend plus rien au sens physique du modèle standard de la physique moderne qui repose sur 2 jambes qui semblent irréconciliables (la relativité générale et la physique quantique). On va voir, un peu plus loin, que le cadre actuel repose en fait sur 3 jambes (la troisième est la thermodynamique), ce qui est toujours plus stable. La perte de sens ne suffit pas à remettre en cause le paradigme. Il faut observer en sus des anomalies qui révèlent l’inconsistance de la théorie de façon intenable. Cette observation ne saurait tarder… elle viendra soit d’une mesure fournie par un accélérateur de particules (par exemple une anomalie dans le moment magnétique anomal du muon), soit d’une mesure astronomique fournie par le télescope James Webb (par exemple une anomalie dans la constante de Hubble), soit (et ce serait la première fois) d’une prise de conscience collective de toutes les « petites » anomalies accumulées, soit d’une observation de phénomène totalement inattendu et prédit par aucune des théories… La difficulté du paradigme actuel, comme d’habitude, c’est que l’utilisation de l’empirisme et le développement d’outils mathématiques généralisés permet aux experts assez facilement dans le cadre de la « recherche normale » de complexifier la théorie à chaque fois qu’un paradoxe apparaît ! Pour un observateur externe non-formaté, la nouvelle crise est évidente. On la devine déjà dans la séquence suivante :

- On observe en 1930AD que les étoiles en périphérie des galaxies tournent beaucoup (beaucoup) plus vite que cela n’est permis par le modèle -> on invente la matière noire qui exerce une force d’attraction pour garantir la stabilité des galaxies (la matière noire représenterait 80% de la matière totale, pourtant on ne l’a jamais vue, c’est un paramètre ajouté dans les équations de la RG!).

- Dans les années 1960AD on constate que la chiralité de certaines particules est asymétrique (neutrino et antineutrino), en parfaite contradiction avec l’un des principes fondamentaux de la physique quantique de l’époque -> on invente l’antimatière et la « brisure spontanée de symétrie ». Le problème c’est que la même chiralité, i.e la différence fondamentale entre gauche et droite, est totalement incompatible avec le principe cosmologique (qui suppose que l’univers est isotrope) de la RG

- En 1986AD, on observe grâce aux nouveaux télescopes que notre galaxie (la Voie Lactée), et l’ensemble du superamas Laniakea dont elle fait partie, est soumise à une force de rotation anormale -> pas de problème, on invente le Grand Attracteur (un objet très (très) massif invisible au centre du superamas)!

- En 1998AD, on observe que l’expansion de l’univers est beaucoup (beaucoup) plus rapide que prévue par le modèle -> toujours pas de problème, on invente l’énergie noire pour conserver le formalisme de la relativité générale. A nouveau on ne l’a jamais vue, à nouveau elle représenterait un pourcentage très élevé de la densité totale d’énergie de l’univers (plus de 70%) et à nouveau c’est un simple paramètre que l’on ajoute pour permettre de conserver le paradigme.

- En 2016AD, dans notre propre système solaire, on constate que les petits objets en circulation au-delà de Neptune (la dernière planète du système solaire) n’ont pas la « bonne » trajectoire -> Il y a quelque chose qui cloche dans les équations de la relativité générale mais on invente une (nécessaire) neuvième planète P9 que l’on n’a jamais vue ! Dans notre propre système solaire…

Pour l’instant ce n’est pas encore assez, le paradigme actuel tient bon la barre! Voyons maintenant ce qu’est le modèle standard de la physique moderne avant de le critiquer de façon constructive.

Le modèle standard de la physique moderne

On appelle communément la nouvelle « théorie du tout » une théorie qui permettrait l’unification du « modèle standard de la physique moderne ». C’est une quête de nombreux physiciens et mathématiciens apparue au 20ièmesiècle, le tout premier d’entre eux étant vraisemblablement Albert Einstein qui y a dédié la fin de sa vie. Pour comprendre la raison et l’intérêt de cette unification, il faut d’abord connaître ce qu’est le modèle standard et quelles en sont les limites.

De façon synthétique, l’objectif du modèle standard est de décrire toutes les interactions élémentaires —i.e. l’origine des forces— qui seraient à l’œuvre dans la nature et qui seraient au nombre de quatre (seulement):

- L’interaction gravitationnelle, i.e. l’attraction et/ou la répulsion entre différentes «masses» qui est à l’origine du mouvement des planètes, des étoiles et de tout l’univers.

- L’interaction électromagnétique, i.e. l’attraction et/ou la répulsion entre porteurs de charges électriques au repos ou en mouvement.

- L’interaction faible, i.e. la répulsion entre particules au niveau subatomique, responsable en particulier de la radioactivité.

- L’interaction forte, i.e. l’attraction responsable (entre autres) de la cohésion au sein d’un noyau atomique (proton et neutron).

Le modèle standard de la physique moderne est en fait la combinaison de deux modèles distincts et d’une règle pour choisir l’un ou l’autre ou … ni l’un ni l’autre:

- La relativité générale —RG— qui décrit les interactions gravitationnelles (une des 4 forces) à grandes distances entre les matières composant l’univers. La mécanique « classique » est une simple approximation des lois de la RG.

- La physique quantique —PQ— qui décrit les trois autres interactions (forte, faible et électromagnétique, les deux dernières ayant été récemment « unifiées » dans ce que l’on appelle les interactions électrofaibles).

- Une règle pour choisir l’une ou l’autre (jamais les deux) ou bien ni l’une ni l’autre, en fonction de la température, de la masse et de la longueur caractéristique des objets étudiés. La règle est déduite du calcul de la « longueur d’onde thermique de de Broglie« .

Le modèle standard de la physique moderne est une science qui se situe quelque part entre les mathématiques et la cybernétique (science des systèmes complexes). Aujourd’hui, la physique commence là où s’arrêtent les mathématiques : dès que l’on doit expérimenter. Bien que tous les modèles physiques actuels reposent sur des outils mathématiques, parfois très abstraits, les mathématiques ne font pas partie de la physique, elles permettent de l’écrire.

D’un autre côté, le modèle standard de la physique moderne n’inclut pas encore formellement la science du vivant, la biologie. En effet, les « objets » de la science du vivant sont trop complexes. D’une certaine manière, la chimie est la frontière actuelle entre la physique et la biologie. La chimie n’est pas non plus complètement incluse dans le modèle standard. On peut dire que le modèle standard décrit la physique des « objets » les plus simples que l’on peut isoler. Cela est exact pour les objets « à faible distance d’interaction » de la physique quantique mais également pour les objets « à grande distance d’interaction » de la relativité générale. On simplifie toujours le modèle au maximum (parfois au delà du raisonnable en prenant des hypothèses non justifiées, que l’on érige alors en principe). Ainsi le modèle standard est à la base de la mécanique et de la cosmologie (mouvement des objets macroscopiques de l’univers).

En revanche, la plupart des phénomènes complexes, quelles que soient leurs dimensions ne font pas partie du modèle standard, mais d’autres sciences qui s’y rattachent partiellement (la chimie, la biologie, l’évolution, la géologie, l’astrophysique, etc), que nous appellerons des systèmes complexes. Notons que l’on ne parle pas non plus de sciences humaines, ni de psychologie ni de sciences sociales dans le modèle standard, mais cela fait partie des systèmes complexes.

Critique de la relativité générale – RG

En 1632AD, Galilée introduit la notion de relativité en faisant l’hypothèse que les lois de la physique restent inchangées dans un référentiel se déplaçant à vitesse constante. De cette hypothèse découle l’idée selon laquelle un objet ne subissant aucune interaction se déplacerait en ligne parfaitement droite, à vitesse constante (c’est la relativité galiléenne).

En 1675AD, Newton introduit la loi d’attraction universelle de la gravitation. Cette force issue de l’interaction entre deux masses « explique » notamment le mouvement rotatif des planètes.

Fin des années 1800AD, on observe que la vitesse de la lumière semble être un maximum impossible à dépasser, ce qui remet en cause le principe de Galilée. En 1905AD, Poincaré étend le principe de Galilée en ajoutant des déformations relatives de l’espace et du temps via un changement de repère —appelé transformation de Lorentz— en fonction d’un paramètre de transformation g faisant intervenir la vitesse v de l’objet et la vitesse c de la lumière — g = 1-v2/c2. Cette transformation introduit des singularités lorsque la vitesse de l’objet atteint la vitesse de la lumière. Poincaré supposait l’existence d’un espace et d’un temps « absolus », ainsi que la présence de l’éther, support non palpable des ondes électromagnétiques, dont la lumière fait partie. Ainsi la vitesse de l’objet en question était-elle toujours référencée par rapport à un repère absolu et ce n’est que par rapport à ce repère absolu que la vitesse de la lumière était une limite indépassable.

La même année (1905AD), Einstein réutilise stricto sensu tous les résultats du modèle de Poincaré mais change « uniquement » la conception de ce que l’on appelle le temps par un tour de passe-passe mathématique: le temps est homogène à une distance divisée par une vitesse ; Einstein postule que le temps multiplié par la vitesse de la lumière (qui est une constante) est physiquement la quatrième dimension de l’univers. Ce faisant, il élimine la notion d’éther et de structure absolue de l’univers pour introduire un nouvel « espace-temps » non absolu. C’est ce que l’on appelle la relativité restreinte.

Minkowski est un mathématicien qui développe en 1907AD un outil (l’espace de Minkowski) qui généralise mathématiquement le concept d’espace-temps correspondant aux idées de Einstein.

En 1915AD, Einstein utilise alors cet outil mathématique puissant pour décrire la façon dont la masse d’un objet déforme cet espace-temps pour « créer » les forces gravitationnelles. C’est la relativité générale —RG. La résolution des équations de RG est tellement complexe, qu’elle nécessite pour les simplifier d’utiliser le « principe cosmologique » selon lequel l’univers est homogène et isotrope. Ce principe, qui élimine la notion de structure absolue, est resté longtemps compatible avec les observations de l’univers. Ce n’est plus le cas depuis 2013AD et les observations du Huge-Large Quasar Group, une structure cosmologique non homogène beaucoup plus grande que ne l’autoriserait le principe… que l’on continue d’utiliser (sinon on ne sait pas résoudre les équations…).

Einstein reviendra plus tard sur la possibilité d’existence d’une substance de type éther répartie dans tout l’univers, mais sans expliquer ce dont il s’agirait et sans revenir à une notion d’absolu. Non, vraiment « Tout est relatif ». Actuellement, avec la notion de champ de Higgs, de particules virtuelles, d’effet Casimir, et d’énergie du vide, il est admis que le vide n’est pas vide, qu’il contient un « je-ne-sais-quoi » qui rappelle finalement la notion d’éther pourtant absente des formules mathématiques de la RG.

Le point fort de la RG est la justesse de certaines de ses « prédictions », pourtant contre-intuitives. Parmi les plus célèbres, on peut citer tout d’abord dès 1915AD le calcul très précis de l’avance du périhélie de Mercure qui apparaissait comme une anomalie inexpliquée de la loi de Newton depuis plusieurs décennies déjà. Ensuite, l’effet de lentilles gravitationnelles observé dès 1919AD lors d’une éclipse totale et qui permis à la communauté scientifique de « vérifier » la théorie de la RG. On peut également citer un phénomène qui nous concerne quasi quotidiennement : l’effet de la désynchronisation d’horloges en mouvement relatif, observé dès 1970AD et pris en compte dans le système GPS pour assurer une bonne précision de localisation. Finalement, l’existence de trous noirs et d’ondes gravitationnelles observés en 2016AD ou encore le décalage vers le rouge, l’effet Lense-Thirring ou la précession de Schwarzschild (des déformations de l’espace-temps de second ordre) sont modélisés par la RG. D’autres « prédictions » compatibles avec la RG sont encore non observées, comme l’existence de trous de ver et de trous blancs, la notion de masse négative et de temps négatif, etc.

Les principales faiblesses de la relativité générale sont les suivantes :

- Le modèle mathématique de la RG repose sur une conjecture étonnante : le temps serait assimilable à une quatrième dimension comparable à une distance. Bergson, philosophe contemporain d’Einstein, spécialiste du temps et de la durée, ne peut pas l’accepter et le fait savoir. Il se fera ridiculiser. Son erreur aura été vraisemblablement d’essayer de se battre avec des arguments physiques et mathématiques alors que ses meilleurs arguments étaient d’ordres philosophiques et intuitifs: notre perception du temps est fondamentalement différente de notre perception de l’espace. Pour assimiler le temps à une distance, il faudrait donner une explication physique des déformations introduites par nos sens, ce qui ne fait pas partie de la RG.

- La nature de la masse, i.e. la nature de l’énergie propre supposée équivalente via la célèbre relation E=m.c2, n’est pas définie. Qu’est-ce que la masse ? et d’ailleurs qu’est-ce que le concept d’énergie ? On ne sait pas.

- A l’origine, la théorie RG était incompatible avec l’observation de l’accélération de l’expansion de l’univers et de l’observation d’une uniformité quasi parfaite du fond diffus cosmologique. Il a été nécessaire d’introduire dans les équations de la RG une « constante cosmologique » représentative d’une hypothétique « énergie noire » pour expliquer ce phénomène répulsif. Encore moins définie que l’énergie classique, cette énergie noire serait distribuée de façon homogène dans l’univers, un peu comme le vide, et représenterait à elle-seule environ 70% de la densité d’énergie de l’univers. C’est un coefficient que l’on ajuste régulièrement dans les formules sans avoir idée de ce qu’il représente physiquement.

- La théorie de la RG était également devenue incompatible avec certains mouvements observés à grande distance en particulier la vitesse de rotation très élevée des étoiles en périphérie des galaxies. En gros, les vitesses angulaires des étoiles ne dépendent pas de leurs distances par rapport au centre des galaxies, comme sur un manège. Tous ceux qui ont pratiqué le manège dans leur enfance savent que ces vitesses devraient conduire à l’expulsion des étoiles de périphérie par effet centrifuge. Pour conserver absolument le formalisme de la RG, on doit alors rajouter une composante attractive, invisible (car on ne l’a jamais vue), que l’on appelle « matière noire» et qui représenterait environ 25% de la densité d’énergie de l’univers et plus de 80% de la matière de l’univers ! Au bilan, entre l’énergie noire et la matière noire, la matière que l’on connait vraiment ne représenterait que 5% de la densité d’énergie de l’univers et 20% de la matière totale.

En résumé, bien que certains phénomènes très étonnants soient très bien modélisés par la RG, on peut dire que les principales forces attractives et répulsives de l’univers sont — sur le plan physique— très mal théorisées par la RG…

Malheureusement, les outils mathématiques de la RG sont tellement compliqués, que seule une poignée de mathématiciens les comprend vraiment. Aussi est-il difficile de pouvoir le « critiquer » sans le rejeter tout entier.

Ce que nous pensons, c’est que la RG était une vraie théorie, bien que ses fondements physiques soient discutables. Cependant, le modèle dérivé est devenu complètement empirique dès lors que l’on a dû, au gré des observations, introduire des « paramètres » purement mathématiques pour rendre compte de 95% de la densité d’énergie de l’univers. Cela suggère que la RG contient un peu de vérité mais que ses « fondements physiques » seraient complètement faux… encore faut-il trouver une nouvelle théorie qui rende compte aussi précisément de tous les phénomènes contre-intuitifs qui respectent la RG et de tous les autres qui ne la respectent pas !

Critique de la physique quantique – PQ

Initiée par Max Planck à la fin du 19ième siècle AD et développée au cours du 20ième siècle AD, la physique quantique —PQ— décrit la matière et ses interactions à très faible distance (interaction faible et interaction forte) ainsi que les interactions électromagnétiques quelle que soit la distance. C’est aujourd’hui un modèle (très) fidèle dans le sens où il permet d’expliquer avec une précision exceptionnelle le résultat de presque toutes les expériences de physique des particules… La théorie repose sur une modélisation mathématique très compliquée manipulant des espèces complexes, des particules réelles et virtuelles, des notions de densité de probabilité et tout un catalogue de 17 particules élémentaires et de « recettes de cuisine » —comme la re-normalisation— pour les associer afin de constituer les objets de physique et de chimie élémentaire que nous connaissons à un niveau microscopique (électrons, protons, atomes, etc).

Le point fort, nous l’avons dit, c’est l’exactitude des mesures obtenues lors des expériences menées dans les accélérateurs de particules.

Les faiblesses de la physique quantiques sont les suivantes :

- La force de gravitation n’est pas décrite, on ne définit pas l’origine de la masse d’une particule mais on se contente de la répertorier dans le catalogue de « paramètres libres ».

- Les spins, les charges électriques sont des propriétés fondamentales des particules mais leur origine et leur sens physique ne sont pas décrits. L’origine même de leur quantification est inexpliquée. A nouveau, ce sont des paramètres libres du catalogue.

- Le sens physique de l’énergie et des niveaux d’énergie n’est pas défini.

- Le temps est une grandeur intrinsèque du formalisme mathématique qui n’est pas défini.

- Les durées de vie des particules sont connues et cataloguées mais pas expliquées.

- L’explication de la nature de la matière et de l’antimatière n’est pas connue, on se contente de la modéliser mathématiquement et de l’avoir observée.

- Du fait de la complexité des modèles, on ne peut pour l’instant comparer la théorie et la pratique que pour des « objets » simples isolés.

- Certains phénomènes contre-intuitifs sont inexpliqués d’un point de vue « physique », bien que parfaitement modélisés dans les équations et le formalisme probabiliste. Par exemple la dualité onde-particule, la superposition d’états, la nature de l’intrication quantique, l’énergie du vide, l’exclusion de Pauli, le principe d’incertitude de Heisenberg, le phénomène de réduction du paquet d’onde, la non-localité observée en 1982AD par Alain Aspect.

- La notion d’ « observateur » est bien présente en PQ mais elle brouille encore plus les pistes ! L’observateur (pouvant être une particule ou un photon) intervient directement dans l’observation à tel point que l’on suppose que sans observateur il n’y aurait pas d’état déterminé… En revanche, la PQ est basée sur un principe anthropique faible, i.e. la présence de l’Homme en tant qu’observateur n’est pas un élément de la modélisation.

- Il reste de grandes inconnues comme l’origine de la nature et la masse des neutrinos (qui tournent tous à gauche !), la nature physique de certains phénomènes à très basses températures (supraconductivité, suprafluidité, effet Hall quantique), etc.

- La PQ n’explique pas le sens profond de la constante de structure fine ni la loi de Koide, qui révèlent un ordre caché.

Finalement, la physique quantique est composée de formules mathématiques compliquées et d’un catalogue de 19 paramètres libres et de constantes fondamentales, que l’on continue de faire croître au gré de l’évolution des moyens de mesures et de simulations. A nouveau, la théorie d’origine s’est muée en modèle empirique… Il est globalement reconnu par les physiciens que personne ne comprend vraiment la physique quantique et qu’il doit exister une théorie physique qui englobe celle-ci et permettrait d’expliquer l’ordre apparaissant manifestement dans le cosmos à petite et grande échelle.

Critique du modèle standard

RG ou PQ, lequel choisir ? Il faut analyser la température, la masse et la longueur caractéristique du système. La température a un sens identique dans chacun des deux modèles: une mesure de l’agitation des objets, i.e de la vitesse de leurs composants. La masse a plusieurs sens différents selon que l’on s’intéresse à l’énergie propre d’un objet (sa masse grave ou pesante) ou à son énergie cinétique (sa masse inertielle). De façon incompréhensible dans le cadre du modèle, mais jamais contredite par l’observation, la masse pesante est exactement égale à la masse inertielle… C’est ce que l’on appelle le principe d’équivalence. La longueur caractéristique d’un système n’est pas très bien définie… Ce sera parfois la dimension de l’objet (étude de la matière), ou bien la dimension du parcours d’un objet (par exemple un rayon d’orbite d’une planète / étoile/ galaxie lors d’étude astronomique) ou bien les deux…

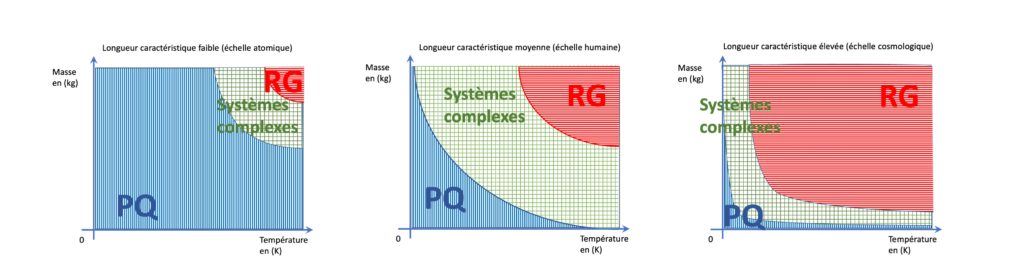

Le seuil permettant de choisir entre la RG et la PQ est donné par la physique statistique en général et la thermodynamique en particulier : la longueur d’onde thermique de De Broglie. Cette longueur varie avec la masse et la température du système suivant une formule simple (cf cours de physique pour les amateurs de formules): plus il fait chaud, plus la longueur d’onde de de Broglie est courte; plus la masse est élevée, plus la longueur d’onde de deBroglie est courte. Pour une température et une masse données, si le phénomène modélisé s’appuie sur des interactions dont la distance est largement inférieure à la longueur d’onde de de Broglie, alors sans hésiter il faut utiliser la PQ. Pour des interactions dont la distance est largement supérieure à la longueur d’onde de De Broglie, pas d’hésitation non plus, c’est la RG qu’il faut choisir! Malheureusement dans le cas de tous les systèmes complexes, on ne peut prendre ni l’une ni l’autre. On se trouve alors dans l’obligation d’utiliser un autre modèle, parmi ceux évoqués plus haut (biologie, géologie, etc). Il semble cependant que l’on puisse conclure que les lois de la thermodynamique, qui permet finalement de choisir entre PQ et RG, s’appliquent dans tous les cas (PQ, RG et systèmes complexes). Nous verrons plus tard que certains principes de la thermodynamique sont en effet des clés du nouveau paradigme… il semble presque évident sur le schéma ci-dessous que l’unification entre PQ et RG passe par la maîtrise de la zone verte, ie celle des systèmes complexes. A gauche, pour les phénomènes dont la longueur caractéristique est très faible (échelles atomiques), c’est sans surprise la PQ qui domine sauf dans un cas extrême: un objet très massif et très chaud. A droite, pour les phénomènes dont la longueur caractéristique est très élevée (échelles cosmologiques), c’est sans surprise la RG qui domine sauf dans un cas extrême: un objet très massif et très froid. Au milieu, pour les phénomènes dont la longueur caractéristique est moyenne (échelle humaine), c’est la thermodynamique des systèmes complexes qui domine, sauf pour les deux extrêmes décrits précédemment.

La complexité inhérente à la généralisation mathématique du modèle standard rend difficile son analyse critique mais il existe un consensus pour identifier huit «anomalies» fondamentales:

- Les deux modèles RG et PQ sont disjoints (l’un déterministe et l’autre non, le temps a deux natures différentes, etc); certains concepts semblent irréconciliables, en particulier la non-localité liée à l’intrication quantique et la nature du temps.

- La chiralité, i.e. la différence entre gauche et droite est une notion clé de la PQ à l’origine de l’antimatière. La chiralité est pourtant exclue de la RG et incompatible avec le principe cosmologique. Pourtant l’antimatière a bien été observée dans les accélérateurs de particules, mais rien n’explique sa « disparition » dans le reste de l’univers.

- La RG est devenue trop empirique avec l’introduction nécessaire de paramètres fondamentaux inexpliqués (énergie et matière noires, Grand Attracteur, etc). 95% de la densité d’énergie de l’univers est empirique.

- Le modèle standard est manifestement incomplet, même pour le phénomènes simples : on constate l’existence d’un ordre caché (origine des 19 paramètres de la PQ, la constante de structure fine, loi de Koide, etc).

- Les unités fondamentales communes à la RG et la PQ (longueur, masse, temps, courant électrique, température thermodynamique, quantité de matière, intensité lumineuse) ont des définitions circulaires donc ne sont jamais déduites logiquement ! Leur « hiérarchie » ou absence de hiérarchie n’est pas cohérente avec les grands principes du paradigme (voir à ce sujet la description non officielle des principes du paradigme Einstein dans le fiche no 2).

- Rien ne prouve que les lois de l’univers soient décrites par les seules 4 interactions du modèle standard. Est-ce qu’il en existe d’autres ? ou au contraire une seule pour tout unifier? En particulier, il n’y a rien dans le modèle actuel qui justifie l’apparition de systèmes aussi complexes que ceux rencontrés dans les êtres vivants (statistiquement improbables !). Cette question nécessite de traiter le principe anthropique, absent du modèle standard.

- La notion de masse n’est pas définie. Elle est même contradictoire mais sauvée par le principe d’équivalence. On a observé récemment que la masse des neutrinos n’est pas nulle, contrairement aux hypothèses du modèle. Or, le fait de la « rajouter » ferait s’écrouler le modèle.

- Les déformations de perceptions de l’observateur (nos sens) ne sont pas considérées. Il y a sur ce point aussi nécessité de traiter le principe anthropique.

Il existe certaines voix qui commencent à s’élever contre le cadre, mais elles sont systématiquement étouffées par les « sachants ». Les experts les plus honnêtes intellectuellement reconnaissent que le modèle standard est à bout de souffle, la plupart d’entre eux cherchent la « théorie du tout » pour unifier les irréconciliables relativité générale et physique quantique (théorie des cordes, théorie quantique à boucles, etc sont des théories physico-mathématiques de généralisation du modèle standard visant à lui rendre une cohérence propre sans pour autant lui redonner un sens physique). Mais très peu d’entre eux sont prêts à appliquer la seule méthode qui a toujours fonctionné dans ce genre de situation : la tabula rasa.

Comme l’a dit Poincaré, « la mathématique c’est l’art de donner le même nom à deux objets différents ». Manifestement, le modèle standard c’est l’art d’avoir donné deux descriptions radicalement différentes d’un même objet, l’univers. Conclusion : le modèle standard est une mimésis (au sens négatif d’Aristote), i.e. doublement éloigné de la vérité !

Pour résoudre les « anomalies » ci-dessus, notre ambition est de proposer un nouveau modèle unifié reposant sur une théorie non-empirique et valable quelle que soit l’échelle considérée. Unifier n’a d’intérêt que si cela permet de comprendre. Le modèle doit donc être intelligible.

Il existe un nouvel espoir: nous avons vu dans la description du paradigme actuel qu’il existe déjà des observations d’une série d’anomalies qui révèlent indiscutablement un « ordre caché ». Nous disposons donc d’ores et déjà de nombreuses observations pour développer un nouveau modèle. Et, une fois de plus en s’inspirant de l’histoire des sciences, on peut croire que les outils formels que l’on va utiliser n’existaient pas lors de la mise en place du précédent paradigme. Les « révolutions » mathématiques du 20ième siècle AD portent sur 2 axes quasiment opposés mais en fait complémentaires et qui, tout deux, adressent la zone verte de la longueur d’onde thermique de de Broglie:

- la théorie des catégories qui permet (presque) l’unification des mathématiques classiques (algèbre générale, analyse, théorie de l’information…) quintessence de la logique classique et utilisée à la fois en RG et PQ. Il ne lui manque que le lien avec les sciences du vivant.

- la cybernétique, qui fait justement ce lien en réconciliant la science du vivant et les sciences formelles, quintessence de la logique intuitionniste et totalement absente à la fois de la RG et PQ, mais qui se trouvait déjà en germe dans la thermodynamique.

Le principal défaut du modèle standard, qui a abouti au mariage de la carpe et du lapin, c’est l’absence d’une méthode rigoureuse (pour ne pas dire une méthode tout court!) permettant de développer un fondement commun à une « théorie du tout » qui englobe toute la physique. Cela passe par un retour au source, avec nécessairement l’unification de la physique et des mathématiques, voire de toutes les sciences … C’est l’objet de la Fiche n°2- Quelle méthode?

Philolaos, le 30 octobre 2022